12/11/2025La strada verso l'AGI: a che punto siamo?

In questi giorni è uscito un paper molto figo (e molto serio) sull’AGI e volevo parlartene.

Ma, se non conosci bene l'argomento, ti do un attimo di contesto.

Da quando sono arrivati gli LLM, tutti hanno cominciato a parlare di Artificial General Intelligence (AGI): un sistema che non solo “capisce” testi, immagini o suoni, ma ragiona, impara e adatta le proprie conoscenze come un essere umano.

Da anni si discute di quando arriverà l’AGI. Ma raramente ci si è chiesti cosa sia esattamente.

Cioè, siamo passati dal considerarla fantascienza a un vero e proprio Santo Graal tecnologico, l’obiettivo di tutte le Big Tech.

Perché, è ovvio, una volta che con la GenAI hai raggiunto livelli di performance impensabili con l’AI tradizionale, devi puntare ancora più in alto per attrarre investimenti.

E ci sono riusciti: OpenAI, DeepMind, Anthropic… tutti hanno cominciato a vendere il sogno, trattando l’AGI come una strategia di posizionamento e come mission.

Esperti e mondo corporate si sono lanciati in previsioni su quando arriverà l’AGI, con stime che si attestano tra il 2026 e il 2029.

OpenAI e DeepMind hanno tentato anche di tracciare delle roadmap in livelli (come per la guida autonoma) per misurare il progresso verso l’AGI.

Ma c’è un problema…

Non abbiamo una definizione vera e propria di AGI e le varie tech company hanno cominciato a definirla un po’ come gli tornava più utile.

Per dirti, Microsoft ha una definizione finanziaria di AGI: “un’AI in grado di generare almeno 100 miliardi di dollari di profitti”.

Questo, secondo me, dice tanto sugli interessi di business più che sugli interessi scientifici intorno al tema.

E quindi?

Beh, senza criteri chiari per riconoscere l’AGI, ognuno può mettere la soglia un po’ dove gli pare.

Per questo ho sempre considerato l’argomento più come una trovata di marketing che come un obiettivo concreto.

Però poi ho letto questo paper, firmato pure da Yoshua Bengio - non esattamente l’ultimo arrivato, diciamo…

E, sarò sincero, potrei essermi in parte ricreduto.️ ⚡️

Lo studio si intitola proprio "A Definition of AGI" e propone un quadro scientifico per misurare l’AGI.

Ed effettivamente la misura!

Lo fa usando la psicometria (una branca quantitativa e statistica della psicologia) e basandosi sulla teoria dell’intelligenza più solida empiricamente che abbiamo.

E i risultati, diciamolo, fanno un po’ cadere il mito dell’AI “quasi umana”. 👀

Ma facciamo un passo indietro e capiamo meglio.

Innanzitutto, i ricercatori partono da una definizione chiara:

“Un’AGI è un’intelligenza artificiale che eguaglia o supera la versatilità e la competenza cognitiva di un adulto ben istruito.”

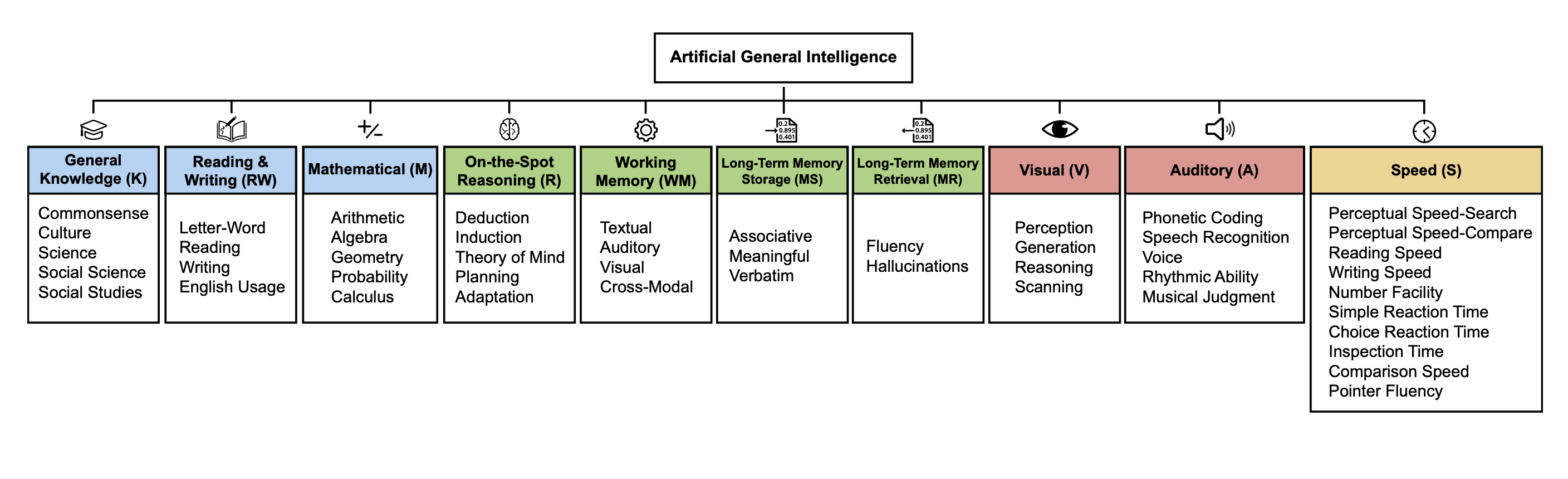

Da qui la definizione diventa operativa: gli autori prendono il modello Cattell-Horn-Carroll (teoria CHC) e lo traducono in 10 domini cognitivi fondamentali.

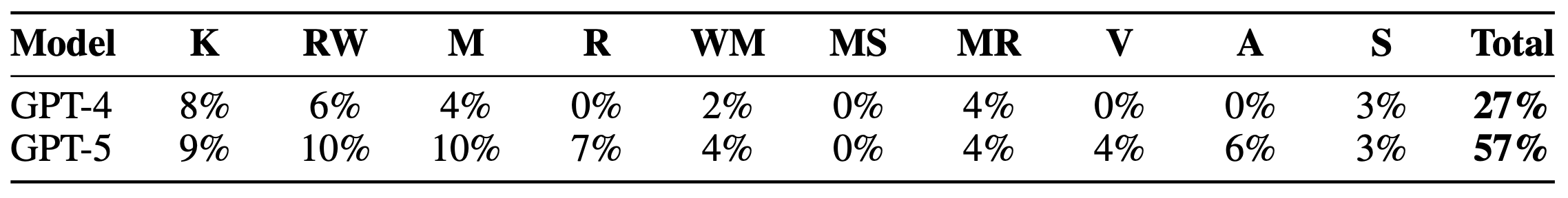

Applicano questa griglia ai modelli esistenti, come GPT-4 e GPT-5, assegnando un punteggio percentuale per ciascun dominio e un AGI Score totale su 100.

Ed ecco i risultati:

Non male, considerando che partivamo da zero qualche anno fa…

Ma ancora distante dal 100%.

Diciamo che l’AGI è ancora lontana, ma non è più utopia.

Lo studio però fa anche altre misurazioni molto interessanti.

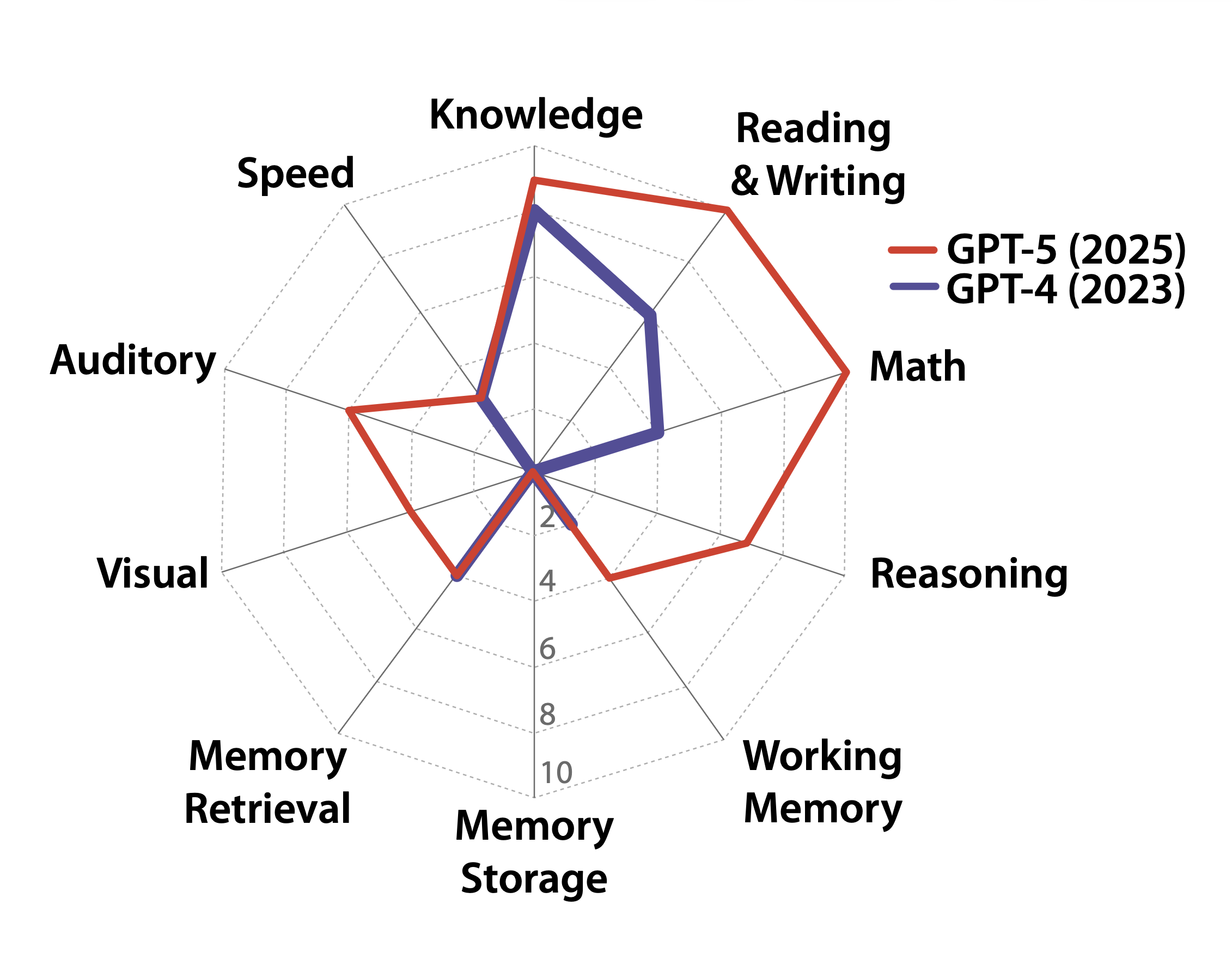

Tipo, il profilo cognitivo che è venuto fuori da questi modelli è frastagliato, come dicono gli autori: eccellenza assoluta in alcuni campi, vuoto cosmico in altri.

I modelli risultano:

🧮 forti in matematica e linguaggio,

🧠 deboli nel ragionamento spontaneo,

💾 completamente fallimentari nella memoria a lungo termine.

Lato memoria, nulla che già non sapessimo, in realtà.

I modelli non possono imparare stabilmente dall’esperienza, perché l’apprendimento avviene solo in fase di training, non durante l'uso.

Ogni conversazione, ogni documento, ogni interazione viene dimenticata appena finisce.

È come parlare con un genio affetto da amnesia.

Senza memoria duratura, niente apprendimento continuo, niente personalizzazione autentica, niente vera intelligenza generale.

Semplicemente compensano.

Gli autori parlano infatti di “capability contortions” - contorsioni cognitive che mascherano le debolezze.

Per capirci:

🔸 non potendo memorizzare, usano finestre di contesto enormi - cioè tengono tutto “in RAM” - per dare l’impressione di continuità;

🔸 quando non riescono a recuperare informazioni interne, si appoggiano al web per colmare i buchi.

È come se uno studente facesse un esame di storia leggendo tutto il manuale mentre risponde.

Impressionante? Sì. Ma non proprio memoria, no? 😅

E questo rende l’idea di Intelligenza Artificiale molto diversa da quella a cui siamo abituati: non un cervello simulato, ma un insieme di competenze scollegate che lavorano insieme.

Hai capito la figata di questo studio?

La metafora che chiude il paper è azzeccata:

“Un sistema di intelligenza è come un motore ad alte prestazioni. La sua potenza effettiva è determinata dal suo componente più debole.”

Puoi avere un motore da Formula 1, pistoni perfetti e turbo da urlo, ma se il serbatoio perde, non andrai lontano. 🏎️

Probabilmente il vero salto verso l’AGI non arriverà solo scalando i modelli, ma ridisegnando le architetture di base.

Però da questa lettura mi porto a casa qualcosa di importante: adesso abbiamo una mappa.

Per la prima volta, non stiamo più discutendo se raggiungeremo l’AGI, ma quali pezzi mancano per arrivarci.

Il progresso è reale e rapidissimo, ma il “motore” dell’AI è ancora fragile.

E quando il suo ultimo componente verrà sistemato, il salto non sarà solo tecnologico: sarà cognitivo, sociale ed economico.

Insomma, oggi non abbiamo ancora l’AGI. Ma, per la prima volta, sappiamo dove guardare per trovarla. 🚀

Giacomo Ciarlini - Head of Content & Education - Datapizza

Simone Conversano - AI Adoption Specialist - Datapizza