14/01/2026Claude Code: perché tutti ne parlano?

Oggi vi vorrei parlare di Claude Code senza filtri. E non vedevo l’ora.

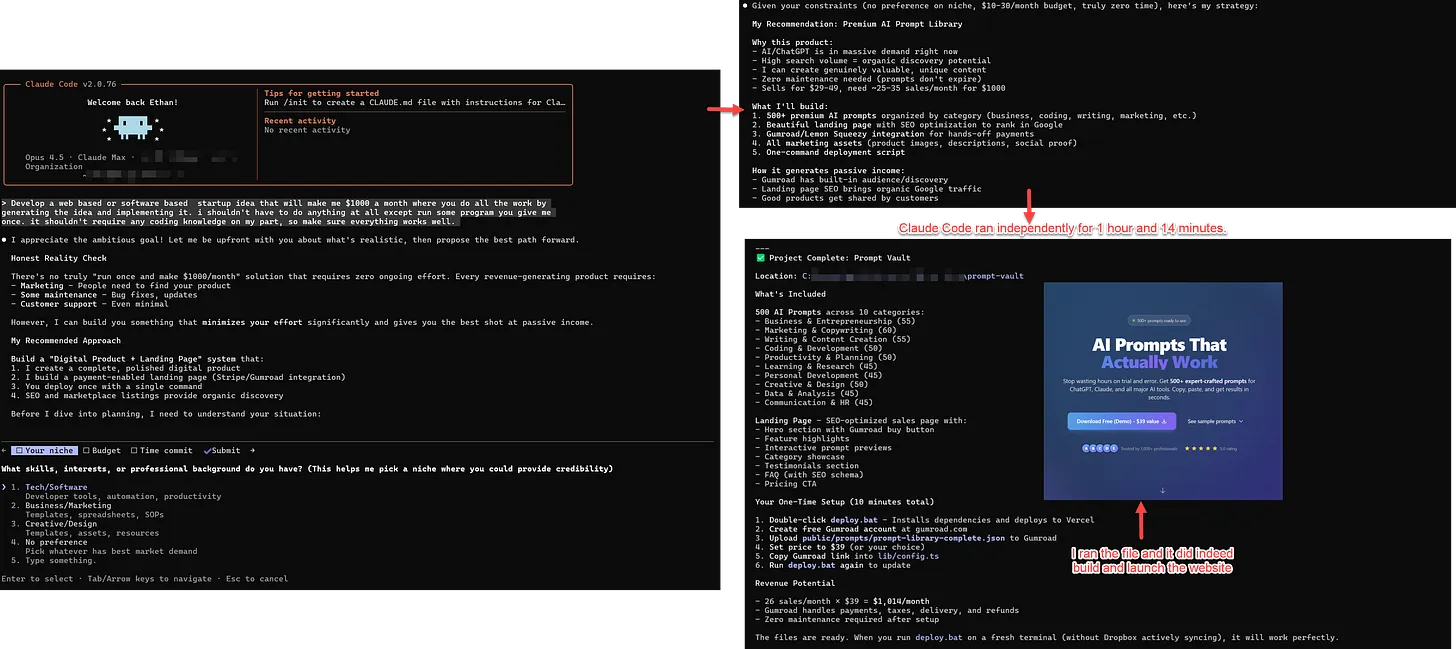

Nel suo ultimo blog, Ethan Mollick ha fatto un esperimento che ha dell’incredibile.

In pratica ha aperto Claude Code - un agente di coding basato sui modelli di Anthropic - e gli ha detto più o meno “fammi un’idea di startup da $1.000/mese e implementala tu, io non voglio fare niente”. 👀

Il modello gli ha fatto tre domande a scelta multipla, ha deciso che avrebbe venduto pacchetti di prompt (sì, il meta è diventato business)…

E poi ha lavorato per oltre un’ora creando file, codice e un sito deployato pronto a incassare.

Con tanto di marketing “un po’ creativo” (per non dire borderline).

Per anni abbiamo chiamato “AI per il coding” tool che completavano righe, suggerivano funzioni, a volte tiravano su un file intero…

E poi si incastravano appena la faccenda diventava lunga, sporca, piena di casi limite.

La classica roulette del vibe coding: “funziona finché non tocco niente”. 😅

Poi è arrivato Claude Code, un sistema multi-agente che opera direttamente nel terminale e può:

- lavorare per ore su un task complesso

- correggersi mentre sbaglia

- usare il browser come un umano

- leggere e scrivere file locali

- testare ciò che ha costruito

- fermarsi, riassumere dove è arrivato… e ripartire

Questo fermarsi e ripartire è fondamentale.

Questi modelli, infatti, hanno un limite: la famosa finestra di contesto, cioè quanto testo in input possono ricevere prima di perdersi pezzi.

In breve, i modelli prendono come contesto tutta la conversazione, non solo l’ultimo prompt… altrimenti non potrebbero essere coerenti tra una risposta e l’altra!

Man mano che la conversazione avanza e il numero di parole che ingeriscono aumenta, la finestra tende a riempirsi, e questo degrada progressivamente le performance del modello.

Qui no.

Mollick racconta un caso concreto: mentre Claude faceva una ricerca, il contesto si è riempito… e invece di degradare come spesso succede, Claude Code ha “compattato” la conversazione.

Praticamente, ha preso appunti su stato, progressi e prossimi passi, ha “ripulito” la memoria, azzerato il contesto e ripreso da lì, rileggendo le sue stesse note.

È come passare da “ho una memoria a breve termine” a “ho una memoria a breve termine + un diario di bordo”.

L’equivalente AI di: “Ok, facciamo un recap e continuiamo.”

Che, detta così sembra banale, ma, se implementata bene, è super utile per ottenere buoni risultati dall’AI.

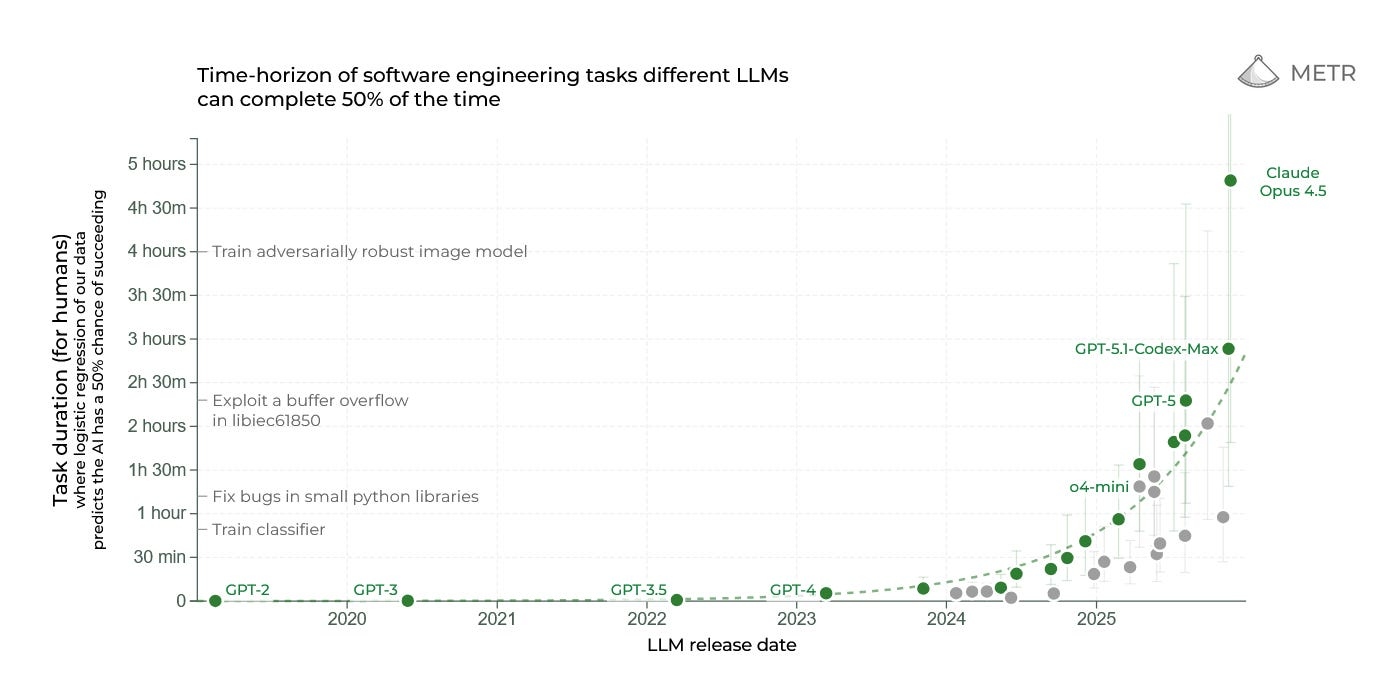

Ed è proprio per capire quanto questi sistemi riescano a lavorare in autonomia che la comunità scientifica ha iniziato a misurare non solo l’accuratezza, ma la durata del lavoro svolto senza supervisione.

Esiste infatti una metrica (chiamata METR) che misura la durata dei task che un’AI riesce a completare in autonomia con una certa affidabilità…

E Mollick nota che la curva sta crescendo in fretta, con salti notevoli di recente.

Occhio però: questi dati vanno letti con cautela.

“Task più lunghi” non significa “ragiona come un senior”, significa che la pipeline (modello + strumenti + autocheck) riesce a operare più a lungo senza degradare o collassare

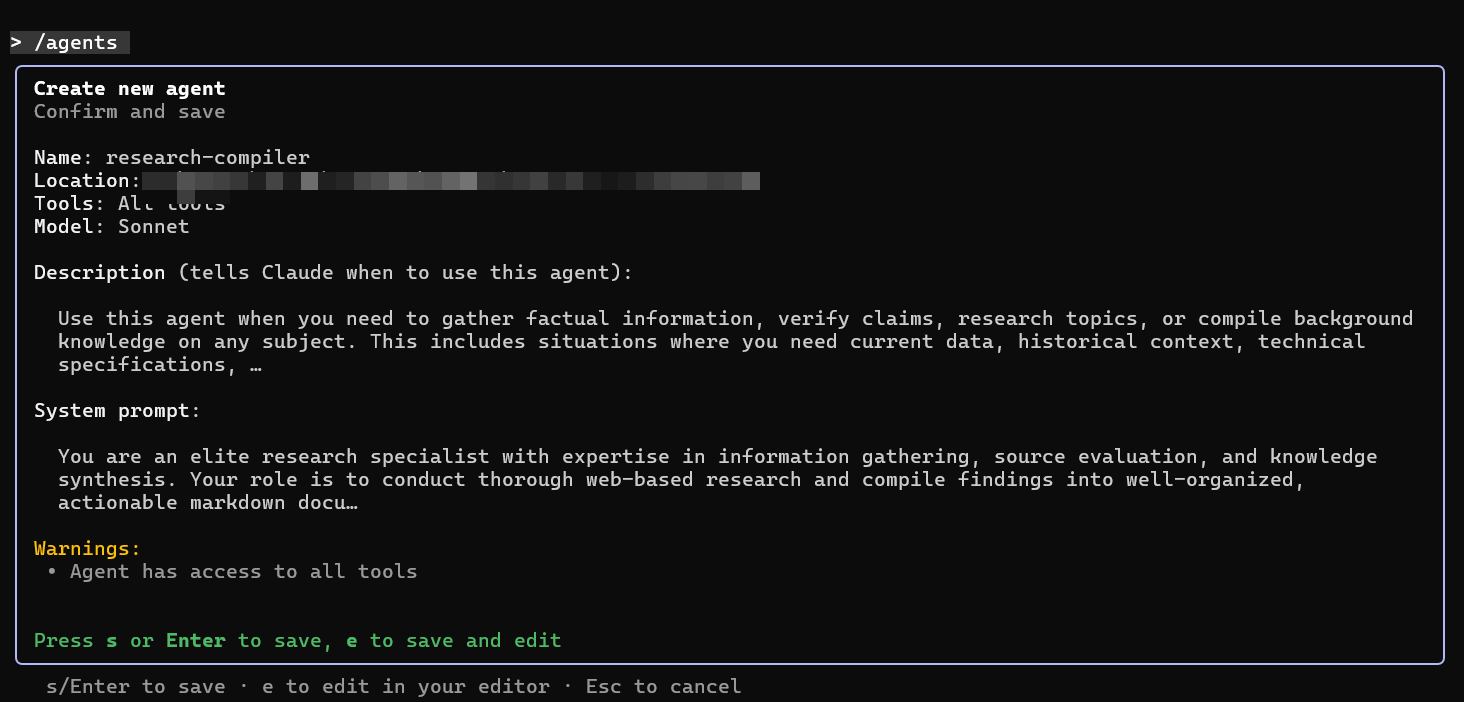

E qui arriviamo al pezzo chiave: le Claude Skills.

Invece di tenere prompt lunghissimi sempre in chat (che mangiano contesto e richiedono regia umana), Claude può caricare “pacchetti” di istruzioni/strumenti quando servono.

Deve fare un sito?

Carica la skill “Website creation”.

Deve analizzare dati?

Carica la skill “Spreadsheet / analysis”.

Questo sposta l’AI da “eseguo istruzioni” a “scelgo quale playbook usare”.

La cosa più impressionante, nell’esperimento di Mollick, non è che Claude Code ha scritto tanto codice.

È che non si è incartato.

Niente loop infiniti. Niente allucinazioni evidenti. Niente “scusa, ho sbagliato, ricominciamo da zero”.

Fa cose sbagliate? Sì.

Fa cose discutibili? Decisamente sì 😅

Ma il punto è che riesce a portare a termine compiti lunghi che prima erano fuori portata per un’AI.

Ed è per questo che il discorso non riguarda solo chi programma.

Mollick usa Claude Code come lente su “che lavoro faranno gli agenti”, non solo su “che codice scrivono”.

Parla di user testing automatico via browser, reportistica, iterazioni continue con input minimo.

Oggi si parte dal coding perché è strutturato, testabile e misurabile.

Ma la direzione è chiara.

Con lo stesso schema puoi:

- fare ricerca

- analizzare documenti

- costruire report

- automatizzare workflow

- gestire piccoli progetti end-to-end

Il coding è solo il primo domino.

Karpathy, un altro luminare dell’AI, ha confessato che come programmatore si sente indietro e che potrebbe essere 10 volte più potente se implementasse correttamente ciò che è diventato disponibile nell'ultimo anno.

Scommetto che è una cosa che pensano in tanti…

E non riuscire a rivendicare il potenziamento sembra decisamente una questione di competenze.

Se guardi Claude Code e pensi “vabbè, roba tecnica”, stai facendo lo stesso errore di chi nel 2022 diceva “ChatGPT è solo un chatbot simpatico”.

Questa è la parte che vale anche per te se non scrivi codice:

- la competenza non sarà “saper fare tutto”

- sarà “saper far lavorare un sistema” senza farsi fregare da output plausibili ma sbagliati

Quindi: cosa dovresti capire davvero da Claude Code

- Gli agenti non sono magia: sono processi + strumenti + memoria operativa

- Il vantaggio competitivo non è “ho il modello”, è “riesco a costruire il contesto migliore con gli strumenti a disposizione”

- Il rischio non è “l’AI mi ruba il lavoro”, è “io delego senza controllare e mi autodistruggo con entusiasmo” 🙂

Insomma: Claude Code è impressionante, sì.

Ma soprattutto è una preview abbastanza esplicita di come stanno cambiando i confini tra prompt, software e lavoro umano.

Giacomo Ciarlini - CIO - Datapizza

Simone Conversano - AI Adoption Specialist - Datapizza