20/01/2026AI e competenze umane: il report di Anthropic

Anthropic ha appena rilasciato un nuovo report sull’uso dell’AI e sul suo impatto economico. E conferma una cosa importantissima.

Si chiama Anthropic Economic Index Report: Economic Primitives ed è, senza esagerare, una di quelle letture che ti costringono a rivedere qualche convinzione comoda su automazione, produttività e “AI che fa tutto da sola”. 👀

Si tratta di un report che prende milioni di interazioni reali con Claude e prova a rispondere a una domanda molto concreta:

Come viene davvero usata l’AI oggi - e cosa significa questo per lavoro, produttività e competenze umane?

Prima di arrivare alle conclusioni del report, facciamo il nostro classico passo indietro.

Anthropic, dopo un primo Economic Index nel 2025, ha deciso di alzare il livello dell’analisi introducendo qualcosa di nuovo: le primitive economiche.

Cioè metriche di base per capire non solo quanto l’AI viene usata, ma come.

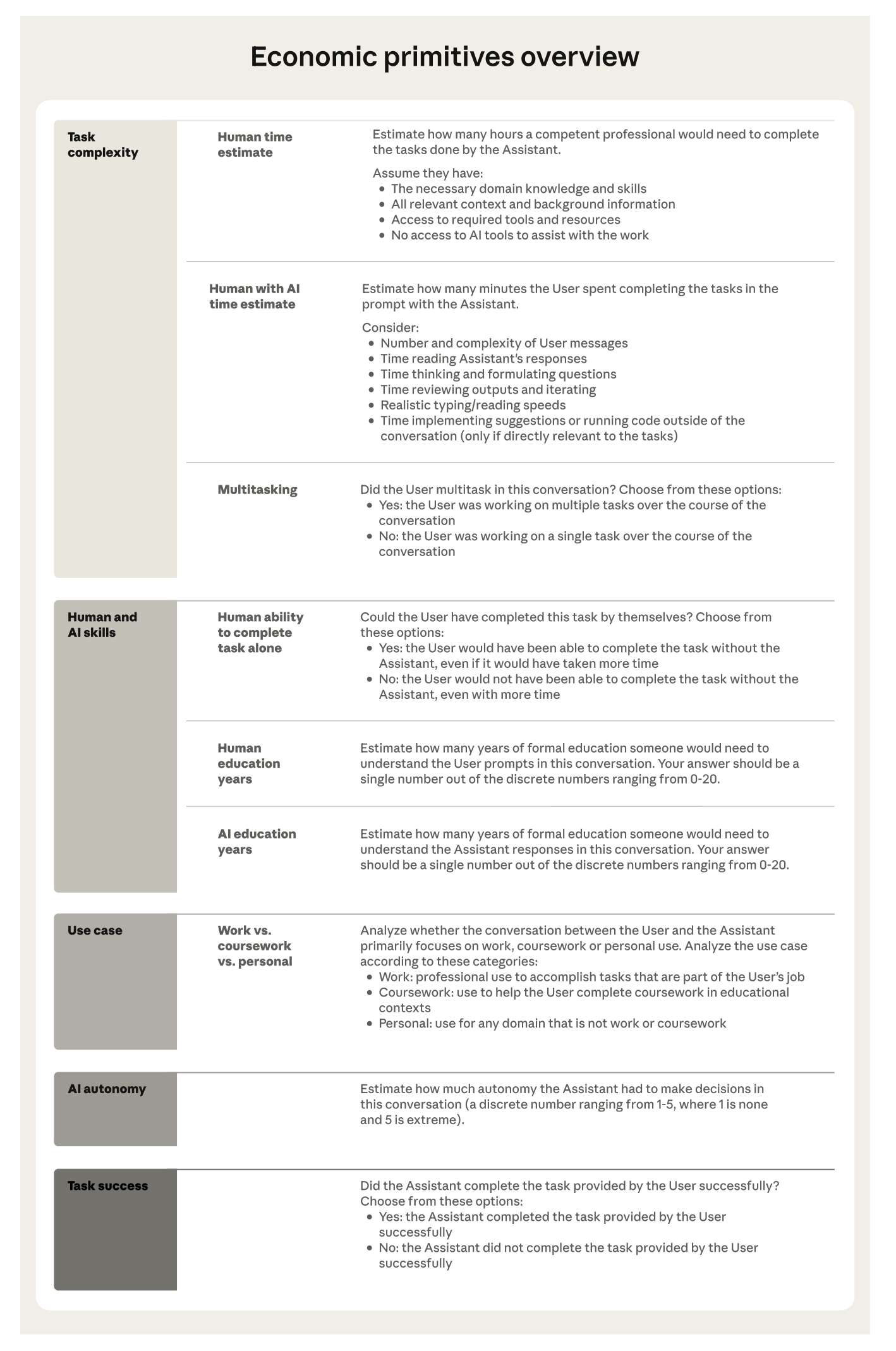

Sono state considerate cinque dimensioni chiave, appunto le primitive:

- Complessità del task (quanto tempo richiederebbe a un umano)

- Skill umane e dell’AI (anni di istruzione per capire input e output)

- Casi d’uso (professionale, educativo, personale)

- Autonomia dell’AI (quanta decisione si delega davvero)

- Successo del task (funziona o no?)

Con questi dati, Anthropic ha analizzato 1 milione di conversazioni su Claude.ai e 1 milione di chiamate API di novembre 2025.

Quindi utilizzo reale, non demo o benchmark.

Ecco i principali risultati:

🔹 L’uso dell’AI è ancora fortemente concentrato su pochi tipi di attività.

I dieci task più comuni coprono da soli circa un quarto di tutte le conversazioni su Claude.ai (24%) e quasi un terzo delle chiamate API (32%).

In pratica, la maggior parte delle persone utilizza l’AI per un numero ristretto di funzioni, soprattutto legate al coding e alla scrittura tecnica.

🔹 Negli Stati Uniti, però, l’adozione si sta diffondendo in modo sorprendentemente rapido.

Le differenze di utilizzo tra stati si stanno riducendo e, se la tendenza continua, si potrebbe arrivare a una distribuzione uniforme (parità di utilizzo pro-capite) in soli 2-5 anni…

Un ritmo circa 10x più veloce rispetto alla diffusione di tecnologie del secolo scorso.

🔹 A livello globale, invece, l’uso dell’AI rimane strettamente correlato al reddito medio dei Paesi.

Dove il PIL pro-capite è più alto, l’adozione è maggiore e più diversificata (lavoro e uso personale), mentre nei Paesi a reddito più basso prevale l’uso per studio e formazione.

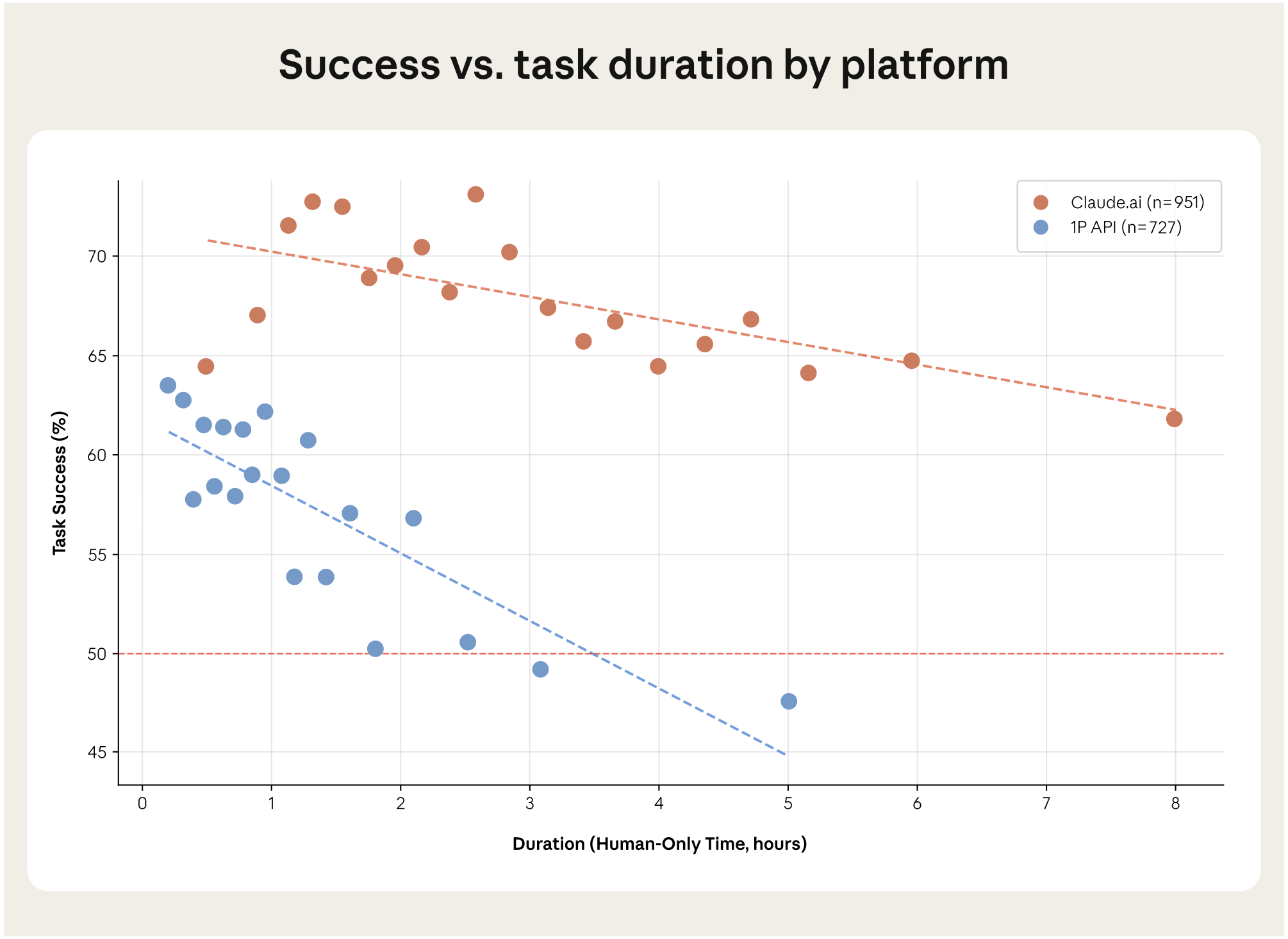

🔹 L’AI garantisce accelerazioni notevoli nei compiti complessi.

Fino a 12x più veloce rispetto al lavoro umano, ma la percentuale di successo cala proprio quando la difficoltà aumenta: più il compito è lungo o articolato, più cresce la probabilità di errore.

🔹 Quando si tiene conto di questa affidabilità reale, le stime di crescita della produttività si ridimensionano.

Dal potenziale teorico di +1.8 punti percentuali l’anno si scende a circa 1.0-1.2 punti correggendo con il tasso di successo e l'affidabilità.

Un impatto comunque significativo ma più realistico.

Ma c’è una parte del report che mi ha decisamente colpito.

Quando si implementa AI nella produttività, si parla sempre di

🔸 automation - la capacità di un modello di eseguire un compito in modo autonomo, con minima o nessuna supervisione umana

vs

🔸 augmentation - una collaborazione attiva in cui l’AI amplifica le capacità umane invece di sostituirle. Ciò che Andrej Karpathy chiama AHI (Augmented Human Intelligence)

Questa è una dicotomia importantissima…

Per trarre il massimo beneficio dalla GenAI, infatti, l’umano deve essere sempre partecipe, validare, supervisionare e costruire insieme al modello l’output finale, secondo il principio dello Human in the Loop.

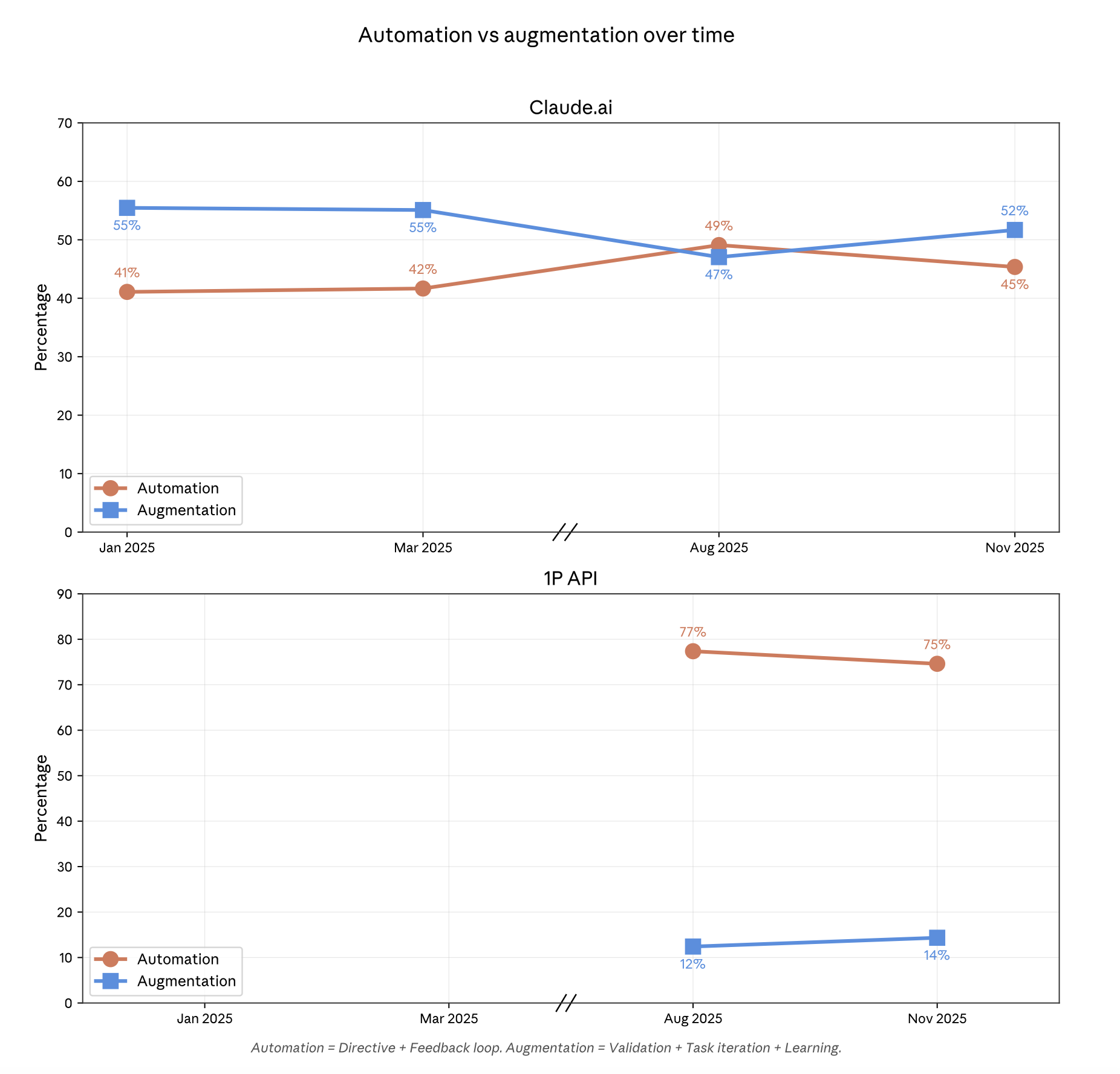

👉 Bene, stando al report, su Claude.ai l’uso è tornato a essere prevalentemente di augmentation:

- 52% collaborazione (iterazione, feedback, apprendimento)

- 45% automazione pura

Sulle API, invece, domina l’automazione (ed è normale: workflow, back-office, codice).

Tradotto: quando l’AI viene usata come strumento cognitivo, le persone non delegano, ma guidano.

E questo è un fatto economico rilevante.

Infatti, il risultato più interessante ed elegante del report è che Anthropic misura una correlazione quasi perfetta tra il livello di istruzione necessario per capire il prompt dell’utente e la sofisticazione della risposta dell’AI (o almeno di Claude).

Ciò suggerisce che le competenze umane determinano l'efficacia del tool e interazioni di maggior qualità portano ad output di maggior qualità.

Quello che dice il report è che Claude può rispondere in modo sofisticato. Ma non lo fa se non lo guidi a quel risultato.

Se ci pensi, questo ha implicazioni enormi:

- l’AI non livella automaticamente le competenze, ma amplifica ciò che già c’è

- chi sa strutturare problemi, ipotesi, contesto… ottiene molto di più

Secondo il report, inoltre, i task più complessi danno i maggiori guadagni di produttività, ma sono anche quelli dove l’AI fallisce più spesso.

La soluzione pratica, allora, non è “delegare di più” ma iterare meglio, riportando il capitale umano al centro.

Infatti:

- nelle conversazioni multi-turno (più scambi di messaggi, correggendo e raffinando passo dopo passo la risposta), Claude mantiene un 50% di successo anche su task stimati in 19 ore di lavoro umano.

- nelle chiamate API single-shot, il tasso di successo scende al 50% già per compiti che richiederebbero circa 3,5 ore.

Non perché Claude “ragioni di più”. Ma perché l’umano rimane nel loop.

Feedback, correzioni, scomposizione del problema: letteralmente ciò che Ethan Mollick definisce co-intelligence.

Insomma, questo report dice una cosa semplice:

👉 L’impatto economico dell’AI non dipende solo dal modello. Dipende da come gli umani lo usano.

Chi ottiene buoni risultati e trae vantaggio non è chi automatizza tutto, ma chi collabora meglio.

E questa è un’ottima notizia!

Perché il futuro del lavoro non è “AI vs umani”, ma l’AI che valorizza le competenze vere.

Un po’ già lo sapevamo, ma ora abbiamo nuovi dati a supporto: l’AI funziona bene se l'utente ha un'expertise di dominio.

Il problema, quindi, non è l’AI, ma la mancanza di competenza.

Senza quella, cosa c’è da amplificare? 😄

Giacomo Ciarlini - CIO - Datapizza

Simone Conversano - AI Adoption Specialist - Datapizza